こんにちは、SEOコンサルタントの谷藤(@go_tanifuji)です。

SEOの情報はネット上に溢れかえっています。

しかし、その中には間違った情報もあり、その見極めが一般の方ですと難しいのが現状です。

効果がない施策を行ってしまうのはまだいいのですが、逆効果になる施策を行ってしまい、順位を大幅に落としてしまうケースをよく見かけます。

今回はその中でも影響度が大きいものをピックアップしましたので、あなたのサイトが間違った施策をしていないか確認してみてください。

noindexの誤使用

noindexはGoogleにインデックス対象外、つまり評価対象外にしてほしいと伝える際に使用します。

強力なシグナルをGoogleに伝えるため、誤った使用をしてしまうとSEOに与えるダメージはかなり大きいものになります。

カテゴリーページにnoindexを設定

「カテゴリページは重複コンテンツになるからnoindexを設定しましょう」という情報をよく見かけます。

これは誤りです。

Googleはカテゴリページをインデックスさせることを推奨しています。

Make Category Pages Indexable & Internal Search Pages Non-indexable

●引用元:Google Webmaster Hangout Notes: November 12th 2019 – DeepCrawl

カテゴリページはインデックスさせ、サイト内検索ページはnoindexさせるのがいい

カテゴリページは関連性のある記事を束ねているページですので、Googleからの評価は高いです。

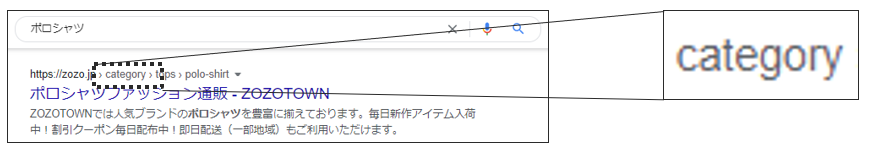

例えばGoogle検索で「ポロシャツ」と検索すると、1位が「ZOZOTOWNのカテゴリページ」です。

ZOZOTOWNのカテゴリページが獲得しているトラフィックは、サードパーティツールで計測すると月間 約1,200,000です。

仮にカテゴリページにnoindexを設定してしまった場合、このすべてのトラフィックを失うことになります。

「All In One SEO Pack」でのミス

WordPressの人気のプラグインで「All In One SEO Pack」があります。

この中に「noindex設定」があるのですが、下記のように「カテゴリにnoindexを使用する」にチェックを入れることを推奨しているサイトをよく見かけます。

この設定をしてしまうと、カテゴリページにnoindexが設定されてしまいますので、設定しないようにして下さい。

●参考:「All In One SEO Pack」でよくある、SEOの致命的なミス

noindexで正規化を行う

正規化とは、重複コンテンツがある場合に正規ページを指定することで、Googleからの評価を1つに統一することをいいます。

こうすることで、検索結果に出したいページを決めることができます。

Googleが推奨している正規化の方法は下記の4つです。

- rel=”canonical”を使用する

- canonical HTTP ヘッダーを使用する

- 301 リダイレクトを使用する

- sitemap.xmlを使用する

しかしnoindexを非正規ページに設定して正規化をするケースを見かけます。

これを行ってしまうと、非正規ページから正規ページへ評価が引き継げなくなります。

Googleも下記のように、正規化にnoindexを使用することを推奨していません。

重複コンテンツに対しては noindex よりも rel=”canonical” を使うことを私は勧める。

noindex というのは、「このページは何もインデックスしてはいけない」と私たちに指示することになる。

rel=”canonical” は、「このページは実際は、別のこちらのページと同じだ」と私たちに指示することになる。両方のページのすべてのシグナルを集めて1つに統合できるから、rel=”canonical” は私たちの助けになる。

一方で、単に noindex にしたり、robots.txt でブロックしたりすると、そのページに関連付いているシグナルは基本的にはすべて失われる。なくなってしまうんだ。

たとえば誰かがページにリンクしてあなたがそのページに noindex を設定していたとすると、どこにもリンクしていないことになる。

対して、rel=”canonical” を設定していれば、そのリンクは正規化しているページに向いていることがわかり、rel=”canonical” に従ってあなたがインデックスしてほしいページへたどっていく。そして、そのページをインデックスに使う。

●引用元:重複コンテンツ対策にはrel=canonicalを推奨、noindexタグではシグナルがすべて失われる | 海外SEO情報ブログ

実際に相談された内容で、「○○というキーワードでAページを上げたいんですど、Bページが上がってしまいます。そのためBページにnoindexを入れてみました。そうしたら、順位が前より下がってしまいました。なぜでしょうか?」というものがありました。

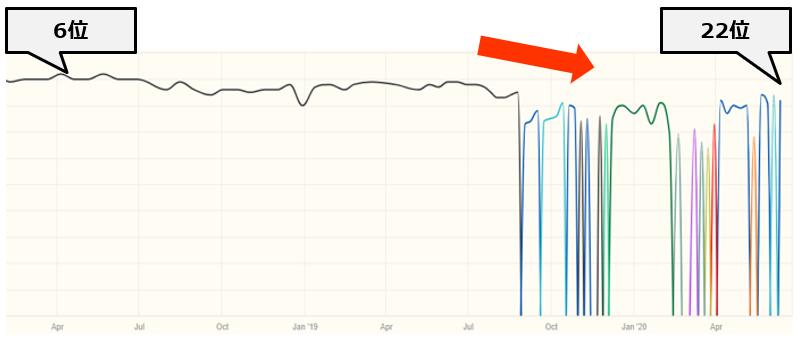

下記は実際に下落したキーワードの「順位」と「ランディングページ」の推移です。

グラフの色の違いは、ランディングページの違いを意味しています。

元々は黒色のグラフが示しているBページが6位にランキングしていました。しかし、Bページにnoindexを入れた後に順位が下落。

その後、青色や水色などが示すページが代わる代わるランキングしているのは、正規ページを失ったために、Googleがどのページを代わりに正規ページにしたらいいかわからなくなり、混乱している状態を表しています。

そしてGoogleがBページ以外のページを代わりにランキングさせようとしますが、Bページの評価がどのページにも引き継がれていないために順位が下がってしまうのです。

削除ツールの誤使用

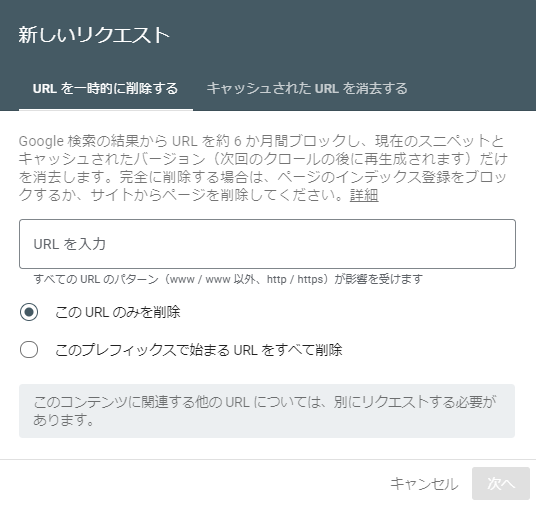

Search Consoleに「削除ツール」というものがあります。

この機能は「一時的にGoogleの検索結果から、指定したページを表示させなくさせる」ものです。

そのため利用用途としては、機密情報を誤って検索結果に出してしまった場合に、早急に検索結果から削除したい場合などが想定されます。

削除ツールで正規化を行う

「削除ツール」と聞くと、指定したページをインデックスから削除するように聞こえますが、これは間違いです。

あくまでGoogle検索結果から一時的に表示させなくするものであって、インデックスを削除するものではありません。

そのため、約6か月後には検索結果に表示されるようになります。

リクエストによってページがブロックされる期間は約 6 か月間です。この期間が経過すると、ブロックされていた情報が再び Google 検索結果に表示されるようになります

●引用元:削除ツール – Search Console ヘルプ

しかし、この機能を勘違いして正規化で使用されてしまうケースがあります。

例えばSSL化を行った際に、「http」はもう使用しないから削除ツールでなくしてしまおう という内容です。

これを行う人のイメージは下記のようになっているはずです。

しかし、実際は下記のように「http」だけでなく「https」も削除対象になります。

なぜかといいますと、この削除ツールは1つのバージョンのみを削除するものではなく、すべてのバージョン(httpとhttps、www有りとwww無し)を削除するものだからです。

残したいバージョンが残ることはなく、URL のすべてのバージョン(http と https、www ありと www なし)が削除されてしまう可能性があります。

●引用元:削除ツール – Search Console ヘルプ

削除ツールの誤使用(?)でサイトが消滅した事例

2020年5月に世界的に有名なソーシャルメディアがGoogleの検索結果から消滅するという出来事が起きました。

アメリカのWEBメディア「Search Engine Roundtable」の記事では、削除ツールの誤使用が原因ではないかと推測しています。

ソーシャルメディア側から正式な発表はなかったため、真相はわかりませんでしたが、実際に起こりえる内容です。

仮にこのような事態になった場合は、「リクエストキャンセル」を行うことで元に戻すことができますので、あわてず下記の手順で行ってください。

検索結果からの一時ブロックをキャンセルするには:

1.削除ツールを開きます。

2.履歴テーブルでリクエストを見つけます。

3.リクエストの横にあるメニューボタンをクリックして、[リクエストをキャンセル] を選択します。

●引用元:削除ツール – Search Console ヘルプ

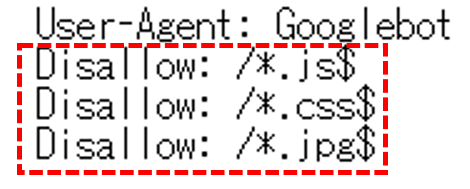

robots.txtでリソースをブロック

robbotx.txtはクローラを制御する機能を持ちます。

大規模サイトでは重要なページにクローラが効率にクロールするように、不必要なページをクロールしないようブロックさせることがあります。

この考えから下記のようにCSSやJavaScriptまでもブロックしてしまうケースがありますが、これは誤りです。

これを行ってしまうと、CSSやJavaScriptが読み込まれないページでの評価をGoogleがしてしまい、本来の順位より低くなる可能性があります。

Disallowing crawling of Javascript or CSS files in your site’s robots.txt directly harms how well our algorithms render and index your content and can result in suboptimal rankings.

robots.txtでJavascriptやCSSファイルのクロールを禁止することは、Googleのアルゴリズムがコンテンツをレンダリングしインデックスすることに悪影響を与え、結果的に最適なランキングにならない可能性があります。

●引用元;Updating our technical Webmaster Guidelines | Google 検索セントラル ブログ

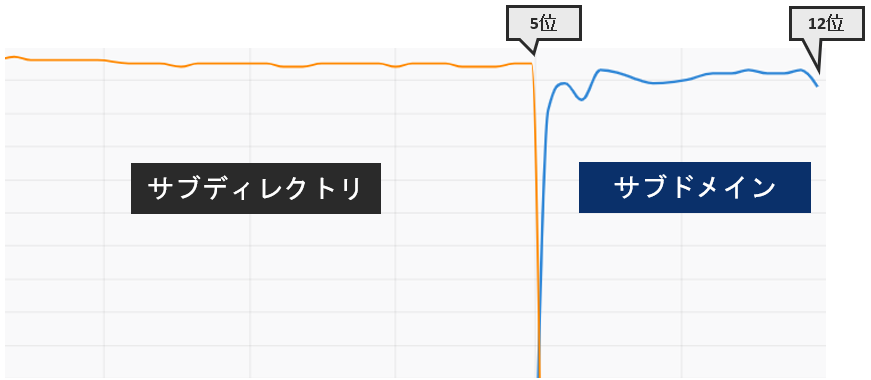

「サブディレクトリ」から「サブドメイン」への移行

Googleはサブドメイン(あるいは、サブディレクトリ)で区切られた部分は、状況によっては別のサイトとして認識されることがあると説明しています。

そのため別サイトとしてGoogleに認識されていたサブドメインをサブディレクトリに移行した場合、別々だったサイトが1つのサイトと認識されることで、ランキングが上昇することがあると述べています。

別サイトとして Google に認識されていたサブドメインをサブディレクトリに移行した場合、別々だったサイトが 1 つのサイトとして認識されるようになり検索結果での状態がよくなることがありうる

●引用元:ドメインオーソリティに似ていなくもない指標をGoogleは持っている。サブドメイン vs. サブディレクトリは「サイト」の区分けに依存する | 海外SEO情報ブログ

逆をいうと、1つサイトとして認識されていたサブディレクトリをサブドメインへ移行することで別々のサイトとして認識されてしまうことがあるということになります。

例えばサブディレクトリで運営していたコラムをサブドメインへ移行するというケースです。

実際にあった例で、 サブドメインへ移行後は下記のように順位が下落しました。

まとめ

「noindex」、「削除ツール」、「robots.txt」はどれもSEOに強い影響を与えます。

SEO歴11年の私でも、この3つを使用するときは緊張します。

そのため正しい使用方法を理解してから活用しましょう。

アイオイクスではSEOを軸としたWebコンサルティングサービスを提供しています。

いわゆるSEOの型に沿った施策ではなく、お客様の事業やWebサイトの構成を踏まえた最適な施策のご提案を重要視しています。SEOにお困りの際はぜひご相談ください。

→SEOコンサルティング サービスページ

アイオイクスでは一緒に働く仲間を募集しています

アイオイクスのWebコンサルティング事業部では、「一緒に挑戦し、成功の物語を共有する」という理想像を掲げ、本質的な取り組みを推進しています。私たちと汎用性の高いスキルを突き詰め、自由に仕事をしていきませんか。

メールマガジンの登録はこちら

SEOに関連する記事の更新やセミナー情報をお届けします。