今回のテーマは「重複コンテンツ」です。

重複コンテンツに関しては、低品質コンテンツと同様に誤った情報が出回っています。

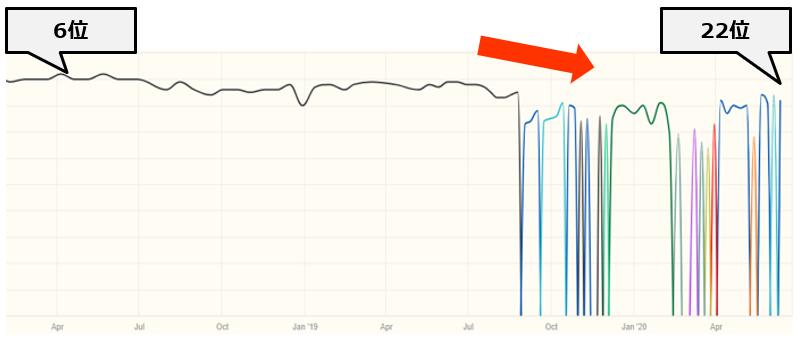

特に誤った対処方法をしてしまい、下記のように順位を大きく下落させてしまうケースをよく見かけます。

このようなことがないように、正しい対処方法をまとめましたので、ぜひ参考にしてみてください。

重複コンテンツとは

Googleは重複コンテンツを下記のように定義しています。

重複するコンテンツとは、ドメイン内または複数ドメインにまたがって存在する、他のコンテンツと完全に同じであるか非常によく似たコンテンツのブロックを指します。

重複コンテンツの作成を避ける | Google 検索セントラル | Google Developers

要するにコンテンツが「全く同じ」か「類似している」状態を重複コンテンツといいます。

重複コンテンツがSEOに与える影響

よくお客様から「重複コンテンツがあるとペナルティを受けるんですよね?」という質問をいただきます。

これは間違いで、Googleは重複コンテンツが存在することは通常起こりえると認識しており、一部を除き、スパム行為としてペナルティを与えることはありません。

重複コンテンツというのは確実に存在するものなんだ。

ブログ記事の一部を引用してそのブログへリンクを張ることとかも当てはまる。

したがって重複コンテンツが起こるとどんな時でもスパムになるというのは事実じゃない。

●引用元:重複コンテンツはスパムでGoogleにペナルティを受ける」は、なぜ間違いなのか

ではどのような重複コンテンツがペナルティの対象になるかというと、下記の2つです。

- 無断複製されたコンテンツ

- サイトの大部分が重複コンテンツ

1.無断複製されたコンテンツ

具体的には下記のようなコンテンツを指します。

他のサイトのコンテンツをコピーし、独自のコンテンツや付加価値を加えることなく転載しているサイト他のサイトのコンテンツをコピーし、(語句を類義語に置き換えたり自動化された手法を使用したりして)若干の修正を加えた上で転載しているサイト

何らかの独自の体系付けやユーザーへの利便性を提供することなく他のサイトからのコンテンツ フィードをそのまま掲載しているサイト

ユーザーに実質的な付加価値を提供することなく、他のサイトの動画、画像、その他のメディアなどのコンテンツを埋め込んだだけのサイト

●引用元:無断複製されたコンテンツ | 検索セントラル | Google Developers

2.サイトの大部分が重複コンテンツ

パンダアップデートの影響を受ける可能性があります。

このアルゴリズムの変更では、低品質なサイトの掲載順位を下げ、同時に、良質なサイトの掲載順位をより適切に評価します。

例えば、ユーザーにとってあまり価値のないサイト、利便性の低いサイト、他のサイトからのコピーで構成されているようなサイトの掲載順位は下がります。

●引用元:Google 検索が、高品質なサイトをよりよく評価するようになりました

そのため、通常のサイトでしたら重複コンテンツがあるからといってペナルティを受けることはありません。

重複コンテンツの対応をすべき理由

では何のために重複コンテンツの対応をしなければいけないかというと、下記の3つの理由からです。

- 検索結果でユーザーに表示する URL を指定するため

- 類似ページや重複ページについてリンクのシグナルを統合するため

- 重複したページのクロールに時間がかかるのを防ぐため

1.検索結果でユーザーに表示する URL を指定するため

優先するページ(正規ページ)を指定しないと、Googleが正規ページを決めてしまいます。

正規 URL を指定しない場合は、Google で正規ページとして最適だと判断されたバージョンまたは URL が選ばれることになります。

●引用元:重複した URL を統合する

そのため、本当はAページを検索結果に出したいのに、正規ページを指定しないがために違うページが検索結果に出てしまう現象が起きることがあります。

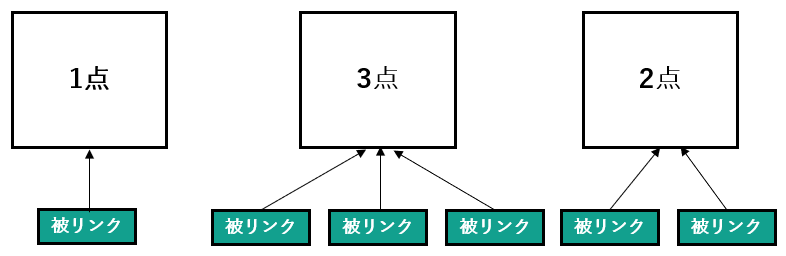

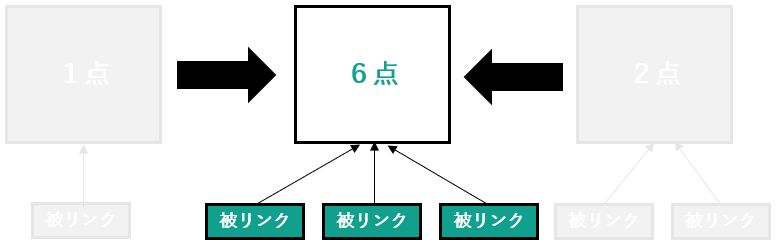

2.類似ページや重複ページについてリンクのシグナルを統合するため

例えば下記のように、各ページが被リンクをもらっているとします。

このままですとGoogleからの評価がバラバラになってしまいます。

正規ページを決めることで、評価を統合することができます。

*点数はわかりやすくするための仮のものです。

3.重複したページのクロールに時間がかかるのを防ぐため

大規模サイトでは重複コンテンツにクロールの時間を割いてしまうと、重要なページがクロールされないという現状が起きることがあります。

正規ページを指定すると、非正規ページのクロール頻度が落ち、重要なページにクローラーが回りやすくなります。

重複コンテンツの見つけ方

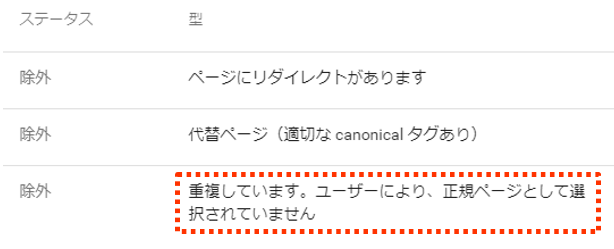

Google Search Consoleの「カバレッジ > 除外 > 重複しています。ユーザーにより、正規ページとして選択されていません」に重複コンテンツが表示されます。

正規ページとして指定されていませんので、次に説明する方法で指定します。

●関連記事:「重複しています。ユーザーにより、正規ページとして選択されていません」とSearchConsoleで表示されたときの対処方法

正規ページの指定方法

Googleが推奨しているのは下記の4つです。

- rel=”canonical”を使用する

- canonical HTTP ヘッダーを使用する

- 301 リダイレクトを使用する

- sitemap.xmlを使用する

1.canonicalタグを使用する

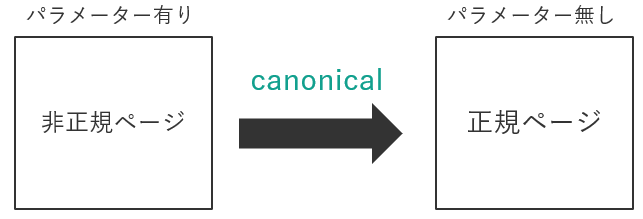

「非正規ページ」と「正規ページ」を両方ユーザーに見せたい場合に使用します。

パラメーター有り無し

例えばリスティング広告を出稿していて、そのランディングページに、下記のように測定用のパラメーターを付けることがあります。

元々のページは下記のようにパラメーターが無いので、

この2つが重複コンテンツになってしまいます。

しかし、どちらもユーザーに見せる必要があるので「canonical」を使用します。

正規ページをパラメーター無しにする必要があるので、パラメーター無しのページに下記のようにマークアップし、

「非正規ページ(パラメータ有り)」から「正規ページ(パラメーター無し」にcanonicalを向けます。

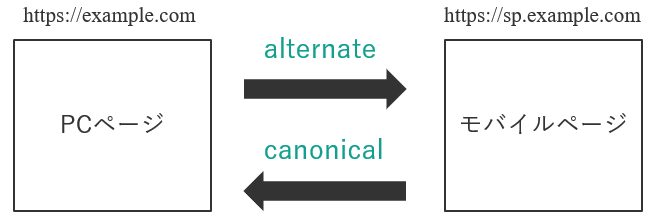

別々のURLでモバイルページが存在

モバイルページを下記のように別々のURLで運営していている場合、

PCページ:example.com

モバイルページ:sp.example.com

PCページからモバイルページへ「alternate」を向け、モバイルページからPCページへ「canonical」を向けます。

<link rel=”canonical” href=”https://example.com/>

<link rel=”alternate” media=”only screen and (max-width: 640px)” href=”https://sp.example.com“>

こうすることで、PCページに対するモバイルページが存在することをGoogleに伝えることができます。

2.canonical HTTP ヘッダーを使用する

PDFファイルのように、HTTPタグを記載できない場合に使用します。

たとえば、複数の URL で 1 つの PDF ファイルを表示する場合、重複した URL について次のような rel=”canonical” HTTP ヘッダーを返して、その PDF ファイルの正規 URL がどれであるかを Google に伝えることが可能です。

Link: <http://www.example.com/downloads/white-paper.pdf>; rel=”canonical”

●引用元:重複した URL を統合する – Search Console ヘルプ

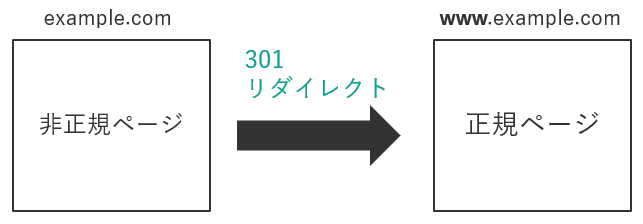

3.301 リダイレクトを使用する

canonicalは「非正規ページ」と「正規ページ」を両方ユーザーに見せたい場合に使用しますが、301リダイレクトは「正規ページ」のみユーザーに見せたい場合に使用します。

例えば「www有り(www.example.com)」と「www無し(example.com)」で、「www有り(www.example.com)」を正規ページにしたい場合です。

この場合は下記のように「非正規ページ(example.com)」から「正規ページ(www.example.com)」に301リダイレクトを向けます。

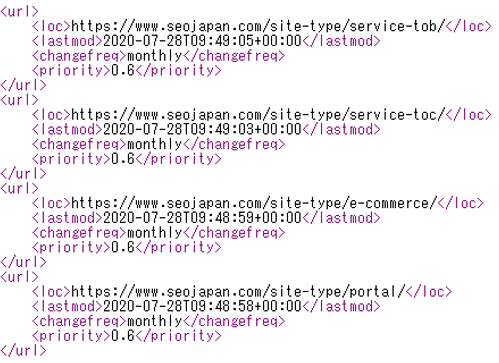

4.sitemap.xmlを使用する

sitemap.xmlとは下記のようなURLのリストで、正規ページをGoogleに伝えるために作成されるものです。

そのためsitemap.xmlをGoogleに送信することで、正規ページがどれなのかGoogleに伝えることができます。

しかし、先に紹介しました「canonical」や「301リダイレクト」よりGoogleに対するシグナルが弱いため、canonicalなどと併用することを推奨します。

rel=canonical マッピングに比べると、Googlebot に対するシグナルとしては効果が弱い

●引用元:重複した URL を統合する – Search Console ヘルプ

参考:Google Search Consoleで「sitemap.xmlのミス」を見つける方法

誤った正規ページの指定方法

下記の3つがあります。

- noindexを使用する

- robots.txtを使用する

- 削除ツールを使用する

1.noindexを使用する

非正規ページに「noindex」を使う方法です。

Googleは下記のように、重複コンテンツにnoindexを使用することを推奨していません。

重複コンテンツに対しては noindex よりも rel=”canonical” を使うことを私は勧める。

noindex というのは、「このページは何もインデックスしてはいけない」と私たちに指示することになる。

rel=”canonical” は、「このページは実際は、別のこちらのページと同じだ」と私たちに指示することになる。両方のページのすべてのシグナルを集めて1つに統合できるから、rel=”canonical” は私たちの助けになる。

一方で、単に noindex にしたり、robots.txt でブロックしたりすると、そのページに関連付いているシグナルは基本的にはすべて失われる。なくなってしまうんだ。

たとえば誰かがページにリンクしてあなたがそのページに noindex を設定していたとすると、どこにもリンクしていないことになる。

対して、rel=”canonical” を設定していれば、そのリンクは正規化しているページに向いていることがわかり、rel=”canonical” に従ってあなたがインデックスしてほしいページへたどっていく。そして、そのページをインデックスに使う。

●引用元:重複コンテンツ対策にはrel=canonicalを推奨、noindexタグではシグナルがすべて失われる | 海外SEO情報ブログ

お客様からよく相談をいただくケースとして、「○○というキーワードでAページを上げたいんですど、Bページが上がってしまいます。なのでBページにnoindexを入れてみました。そうしたら、順位が前より下がってしまいました。なぜでしょうか?」というものです。

なぜ下がったかというと、Googleが評価していたBページにnoindexを入れたことで、Bページの評価がどのページにも引き継がれることもなく「0」になってしまったためです。

そしてGoogleがBページ以外のページを代わりにランキングさせようとしますが、Bページより評価が低いため順位が下がってしまうのです。

それが冒頭でふれました下記の状態です。

グラフの色の違いは、ページの違いを意味しています。

元々は黒色のグラフが示しているページが6位にランキングしていました。しかし、このページにnoindexを入れてしまったために順位が下落。

青色や水色などが示すページが代わる代わるランキングしているのは、正規ページを失ったために、Googleがどのページを代わりに正規ページにしたらいいかわからなくなり、混乱している状態を表しています。

2.robots.txtを使用する

この方法もGoogleは推奨していません。

Google は、ウェブサイト上の重複コンテンツに対するクローラのアクセスをブロックすることは、robots.txt ファイルかその他の手段かにかかわらず、おすすめしていません。

●引用元:重複コンテンツの作成を避ける – Search Console ヘルプ

noindexと同様に非正規ページの評価が完全になくなり、正規ページに引き継がれなくなってしまうためです。

●参考:「robots.txt によりブロックされましたが、インデックスに登録しました」とSearch Consoleに表示された時の対処方法

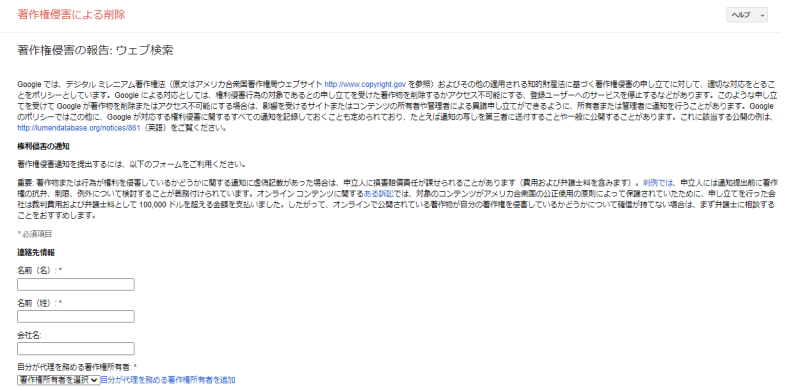

3.削除ツールを使用する

Search Consoleに「削除ツール」というものがあります。

これは、Googleの検索結果から一時的に表示されないようにするものです。

具体的には指定したページのすべてのバージョン(「http」 と 「https」、「www あり」と 「www なし」)が対象になります。

しかし、指定したページのみ削除するものだと勘違いしてしまうケースが多く、正規ページの指定方法として使用してしまい、SEOに悪影響を与えることがあります。

例えば、「www有り」を正規ページにしたいがために、「www無し」を削除ツールを用いて削除してしまった場合、「www有り」も「www無し」も両方削除されてしまいます。

サイトの正しい「バージョン」をインデックスに登録する目的でこのツールを使用しないでください。

多くのサイトでは、同じ HTML コンテンツやファイルに複数の URL からアクセスできるようになっています。

このようなサイトが重複して検索結果に表示されないようにするには、おすすめの正規化の方法についてのページをご覧ください。

検索結果に表示させたくない URL をブロックする目的で URL ツールを使用しないでください。

このような場合に削除ツールを使用しても、ページの残したいバージョンが残ることはなく、URL のすべてのバージョン(http と https、www ありと www なし)が削除されてしまう可能性があります。

●引用元:削除ツール – Search Console ヘルプ

このようなことがないように、Googleが推奨している方法で正規ページを指定するようにしましょう。

他サイトで重複コンテンツがある場合の対処方法

今まで説明した内容は自サイト内に重複コンテンツがある場合でした。

しかし重複コンテンツは他サイトでも発生します。

例えば下記のようなケースです。

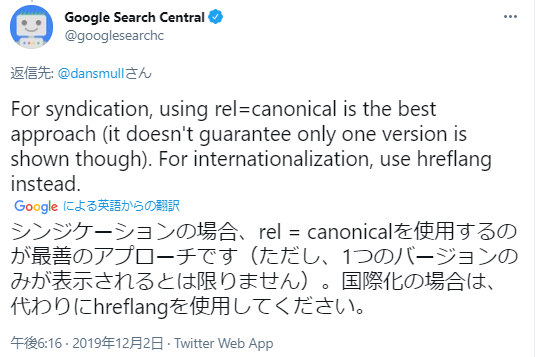

コンテンツシンジケーションの場合

コンテンツシンジケーションとは、コンテンツを自サイトだけでなく、第三者のサイトにも配信や提供する仕組みのことをいいます。

ニュースサイトがいい例ですね。

何もしないと配信先のサイトと重複コンテンツとなってしまうので、自サイトのコンテンツが正規ページであることをGoogleに伝える必要があります。

Googleが推奨しているのは下記の2つです。

- 配信先から配信元へcanonicalを設置

- 配信元にnoindexを設置

シンジケーションは注意して行う: コンテンツを他のサイトにシンジケーション提供している場合、あなたの判断とは無関係に、Google で最適と判断されたバージョンが常に表示されます。ただし、コンテンツがシンジケーション提供される各サイトに元記事へのリンクを含めることは有効です。

また、シンジケーション提供したコンテンツを使用するユーザーに、提供先のサイト上のバージョンがインデックスに登録されないよう、noindex メタタグで検索エンジンをブロックするように依頼することもできます。

●引用元:重複コンテンツの作成を避ける | Google 検索セントラル | Google Developers

こうすることで、配信元であるあなたのコンテンツが正規ページであることをGoogleに伝えることができます。

コンテンツが盗用された場合

悪意ある人があなたのコンテンツを無断で掲載することがあります。

重複コンテンツになる上に、まれに盗用したサイトの方をGoogleが正規ページとしてしまうケースがあります。

まれに、コンテンツを無断でホストしている外部サイトの URL が Google のアルゴリズムで選択されることがあります。

●引用元:重複コンテンツの作成を避ける – Search Console ヘルプ

このような事態になりましたら、デジタルミレニアム著作権法(DMCA)に基づく通知をGoogleに提出することを推奨します。

Googleの申請フォームから提出でき、Google に検索結果から除外するようリクエストできます。

●参考記事:虚偽のDMCA申請の通知が届いたらできること【DMCAの悪用に屈しない為に】

重複コンテンツの発生を予防する方法

下記の2つがあります。

- 定型文の繰り返しをできるだけ少なくする

- 類似するコンテンツをできるだけ少なくする

定型文の繰り返しをできるだけ少なくする

例えば著者情報の詳細を記事ごとに書いてしまうと、その部分が重複してしまいます。

そのため記事には著者情報の要約を記載し、詳細な著者情報を記載したページを作成し、そこへ内部リンクを張ります。

これにより、定形文の繰り返しを少なくすることができます。

定型文の繰り返しをできるだけ少なくする: たとえば、著作権に関する説明をすべてのページの下部に表示する代わりに、短い要約文を組み込んで詳細情報のページにリンクするようにします。

●引用元:重複コンテンツの作成を避ける | 検索セントラル | Google Developers

類似するコンテンツをできるだけ少なくする

同じような内容のページがある場合は、1つにまとめることを検討します。

正規化を行うこともできますが、そもそも2つのページが存在する意味がないのであれば、検討する余地があります。

類似するコンテンツをできるだけ少なくする: 類似するページが多数存在する場合は、各ページに内容を追加するか、または 1 つにまとめます。たとえば、旅行サイトで 2 つの都市を別々のページで紹介しているが、ページ内の情報は同じである場合は、両方の都市を紹介する 1 つのページにまとめるか、各ページに内容を追加して、それぞれの都市に関する独自のコンテンツを含めます。

●引用元:重複コンテンツの作成を避ける | 検索セントラル | Google Developers

まとめ

重複コンテンツの基本と対象法を解説しました。

重複コンテンツそのものよりも、誤った対処法の方がSEOへの悪影響があることがわかっていただけたと思います。

間違ってもnoindexやrobots.txtを使用しないようにしてくださいね。

では、また次の記事でお会いしましょう!

アイオイクスではSEOを軸としたWebコンサルティングサービスを提供しています。

いわゆるSEOの型に沿った施策ではなく、お客様の事業やWebサイトの構成を踏まえた最適な施策のご提案を重要視しています。SEOにお困りの際はぜひご相談ください。

→SEOコンサルティング サービスページ

アイオイクスでは一緒に働く仲間を募集しています

アイオイクスのWebコンサルティング事業部では、「一緒に挑戦し、成功の物語を共有する」という理想像を掲げ、本質的な取り組みを推進しています。私たちと汎用性の高いスキルを突き詰め、自由に仕事をしていきませんか。

メールマガジンの登録はこちら

SEOに関連する記事の更新やセミナー情報をお届けします。